ProConsultant Informatique et Videomenthe deviennent Bminty!

L’IA Générative Whisper d'Open AI

au service de la transcription

3 mai 2024

L’AI générative dans le milieu de la vidéo professionnelle, on en parle beaucoup, notamment côté création : production d’images, retouches de vidéos poussées, ajout d’effets, etc.

Mais l’émergence de l'intelligence artificielle générative ouvre également de nouvelles perspectives dans l’univers de la transcription, de la traduction et du sous-titrage ! Au cœur de cette révolution se trouve la technologie Whisper, qui repousse les limites du speech to text. On vous en dit plus dans cet article.

Whisper, le nouveau ChatGPT du speech to text ?

Lorem ipsum dolor sit amet, consectetur adipisicing elit, sed do eiusmod tempor incididunt ut labore et dolore magna aliqua. Ut enim ad minim veniam, quis nostrud exercitation ullamco laboris nisi ut aliquip ex ea commodo consequat. Duis aute irure dolor in reprehenderit in voluptate velit esse cillum dolore eu fugiat nulla pariatur. Excepteur sint occaecat cupidatat non proident, sunt in culpa qui officia deserunt mollit anim id est laborum.

LOREM IPSUM

Whisper utilise des modèles génératifs entraînés sur un très grand volume de données (680 000 heures de données supervisées multilingues et multitâches) pour produire des sous-titres précis et naturels, qui se rapproche de ce que pourrait réaliser un humain.

La particularité de Whisper réside dans sa capacité à comprendre le contexte global de l'audio et à générer du texte qui capture non seulement les mots prononcés, mais aussi leur signification et leur intention. Et c’est là toute la puissance de Whisper !

Nous avons par exemple testé en lui fournissant un audio avec une phrase coupée au milieu. Et bien Whisper a terminé la phrase pour nous (et ça avait du sens !), là où les autres outils de transcription se sont « contentés » de transcrire mot à mot la phrase, et donc de s’arrêter en plein milieu.

Cette approche permet donc à Whisper de produire des sous-titres de haute qualité même dans des conditions audio difficiles, comme exemple la présence d'accents variés, de bruits de fond ou de langage technique ou complexe.

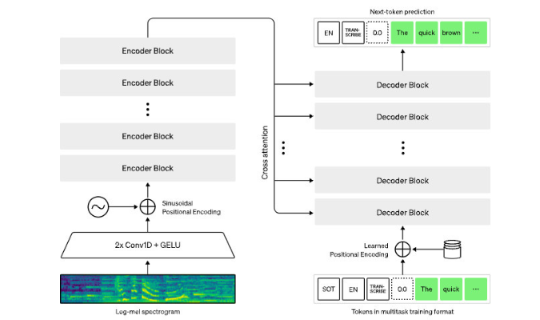

Architecture de Whisper

o Whisper utilise une architecture end-to-end simple, sous forme d’un Transformateur encodeur-décodeur.

o Le flux de travail est le suivant :

- L’audio d’entrée est divisé en segments de 30 secondes.

- Ces segments sont convertis en spectrogrammes log-Mel qui, pour faire simple, imite la façon dont l'oreille humaine répond à différentes fréquences.

- Ils sont ensuite envoyés dans un encodeur.

- Un décodeur est entraîné pour prédire le texte correspondant, avec des tokens spéciaux pour effectuer des tâches telles que l’identification de la langue, les horodatages au niveau des phrases, la transcription multilingue et la traduction de la parole vers l’anglais.

Limitations actuelles de Whisper

Whisper est un système relativement récent, qui connait quelques limitations pour l’instant.

1. Performance par rapport à LibriSpeech

LibriSpeech est un corpus de près de 1000 heures de discours anglais lu à une fréquence d'échantillonnage de 16 kHz. Ce corpus est utilisé pour l'entraînement des modèles en reconnaissance automatique de la parole (ASR)

Whisper n’a pas été spécifiquement entraîné pour surpasser les modèles spécialisés de LibriSpeech, qui sont très performants sur des sujets bien spécifiques.

Cependant, lorsque l’on mesure les performances de Whisper sur de nombreux ensembles de données diversifiés, on constate qu’il est beaucoup plus robuste et commet 50 % moins d’erreurs que ces modèles.

2. Taille des fichiers audio

Whisper peut traiter des fichiers audio de n’importe quelle longueur, tant que la taille du fichier d’entrée est inférieure à 25 Mo.

Pour les fichiers plus longs, vous pouvez suivre les directives d’OpenAI concernant les entrées longues.

3. Langues

- Whisper est essentiellement entraîné sur des données en anglais (2/3 des données). Cela peut, pour l’instant, entraîner une moins bonne prise en charge sur certaines langues.

- Si Whisper peut transcrire dans un très grand nombre de langues, la traduction n’est actuellement disponible que vers l’anglais.

Comment utiliser Whisper ?

Pour l’instant, tester Whisper requiert des compétences techniques que nous n’avons pas tous ! En effet, l’utiliser sur votre laptop suppose d’installer plusieurs outils (Python, PIP, Chocolatey, FFMPEG et évidemment Whisper), puis d’exécuter des lignes de commande pour convertir votre audio en texte.

Il existe toutefois une solution relativement accessible, pour tous ceux qui n’auraient pas les compétences techniques requises. Google Colab (pour Colaboratory), une plateforme NoCode créée par Google, qui facilite l’exécution de commandes Python directement depuis un navigateur ! Si vous maîtrisez l'anglais, il vous suffit alors de suivre les instructions indiquées sur cette plateforme et de générer la transcription texte d’un fichier audio.